Справочная информация по семейству видеокарт Nvidia GeForce 20

После длительного застоя на рынке графических процессоров, связанного с несколькими факторами, в 2018 году вышло новое поколение GPU компании Nvidia, сразу обеспечившее переворот в 3D-графике реального времени! Аппаратно ускоренной трассировки лучей многие энтузиасты ждали уже давно, так как этот метод рендеринга олицетворяет физически корректный подход к делу, просчитывая путь лучей света, в отличие от растеризации с использованием буфера глубины, к которой мы привыкли за много лет и которая лишь имитирует поведение лучей света. Об особенностях трассировки мы написали большую подробную статью.

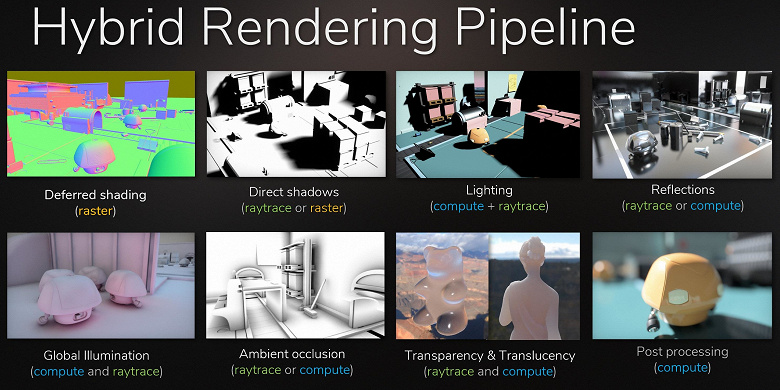

Хотя трассировка лучей обеспечивает более высокое качество картинки по сравнению с растеризацией, она весьма требовательна к ресурсам и ее применение ограничено возможностями аппаратного обеспечения. Анонс технологии Nvidia RTX и аппаратно поддерживающих ее GPU дал разработчикам возможность начать внедрение алгоритмов, использующих трассировку лучей, что является самым значительным изменением в графике реального времени за последние годы. Со временем она полностью изменит подход к рендерингу 3D-сцен, но это произойдет постепенно. Поначалу использование трассировки будет гибридным, при сочетании трассировки лучей и растеризации, но затем дело дойдет и до полной трассировки сцены, которая станет доступной через несколько лет.

Что предлагает Nvidia уже сейчас? Компания анонсировала свои игровые решения линейки GeForce RTX в августе 2018 года, на игровой выставке Gamescom. GPU основаны на новой архитектуре Turing, представленной еще чуть ранее — на SIGGraph 2018, когда были рассказаны лишь некоторые подробности о новинках. В линейке GeForce RTX объявлено три модели: RTX 2070, RTX 2080 и RTX 2080 Ti, они основаны на трех графических процессорах: TU106, TU104 и TU102 соответственно. Сразу бросается в глаза, что с появлением аппаратной поддержки ускорения трассировки лучей Nvidia поменяла систему наименований и видеокарт (RTX — от ray tracing, т. е. трассировка лучей), и видеочипов (TU — Turing).

Почему Nvidia решила, что аппаратную трассировку необходимо представить в 2018-м? Ведь прорывов в технологии производства кремния не было, полноценное освоение нового техпроцесса 7 нм еще не закончено, особенно если говорить о массовом производстве таких больших и сложных GPU. И возможностей для заметного повышения количества транзисторов в чипе при сохранении приемлемой площади GPU практически нет. Выбранный для производства графических процессоров линейки GeForce RTX техпроцесс 12 нм FinFET хоть и лучше 16-нанометрового, известного нам по поколению Pascal, но эти техпроцессы весьма близки по своим основным характеристикам, 12-нанометровый использует схожие параметры, обеспечивая чуть большую плотность размещения транзисторов и сниженные утечки тока.

Компания решила воспользоваться своим лидирующим положением на рынке высокопроизводительных графических процессоров, а также фактическим отсутствием конкуренции в момент анонса RTX (лучшие из решений единственного конкурента с трудом дотягивали даже до GeForce GTX 1080) и выпустить новинки с поддержкой аппаратной трассировки лучей именно в этом поколении — еще до возможности массового производства больших чипов по техпроцессу 7 нм.

Кроме модулей трассировки лучей, в составе новых GPU есть аппаратные блоки для ускорения задач глубокого обучения — тензорные ядра, которые достались Turing по наследству от Volta. И надо сказать, что Nvidia идет на приличный риск, выпуская игровые решения с поддержкой двух совершенно новых для пользовательского рынка типов специализированных вычислительных ядер. Главный вопрос заключается в том, смогут ли они получить достаточную поддержку от индустрии — с использованием новых возможностей и новых типов специализированных ядер.

| Графический ускоритель GeForce RTX 2080 Ti | |

|---|---|

| Кодовое имя чипа | TU102 |

| Технология производства | 12 нм FinFET |

| Количество транзисторов | 18,6 млрд (у GP102 — 12 млрд) |

| Площадь ядра | 754 мм² (у GP102 — 471 мм²) |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12_1 |

| Шина памяти | 352-битная: 11 (из 12 физически имеющихся в GPU) независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | 1350 (1545/1635) МГц |

| Вычислительные блоки | 34 потоковых мультипроцессора, включающих 4352 CUDA-ядра для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32 |

| Тензорные блоки | 544 тензорных ядра для матричных вычислений INT4/INT8/FP16/FP32 |

| Блоки трассировки лучей | 68 RT-ядер для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 272 блока текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 11 (из 12 физически имеющихся в GPU) широких блоков ROP (88 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка подключения по интерфейсам HDMI 2.0b и DisplayPort 1.4a |

| Спецификации референсной видеокарты GeForce RTX 2080 Ti | |

|---|---|

| Частота ядра | 1350 (1545/1635) МГц |

| Количество универсальных процессоров | 4352 |

| Количество текстурных блоков | 272 |

| Количество блоков блендинга | 88 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 352-бит |

| Объем памяти | 11 ГБ |

| Пропускная способность памяти | 616 ГБ/с |

| Вычислительная производительность (FP16/FP32) | до 28,5/14,2 терафлопс |

| Производительность трассировки лучей | 10 гигалучей/с |

| Теоретическая максимальная скорость закраски | 136-144 гигапикселей/с |

| Теоретическая скорость выборки текстур | 420-445 гигатекселей/с |

| Шина | PCI Express 3.0 |

| Разъемы | один HDMI и три DisplayPort |

| Энергопотребление | до 250/260 Вт |

| Дополнительное питание | два 8-контактных разъема |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $999/$1199 или 95990 руб. (Founders Edition) |

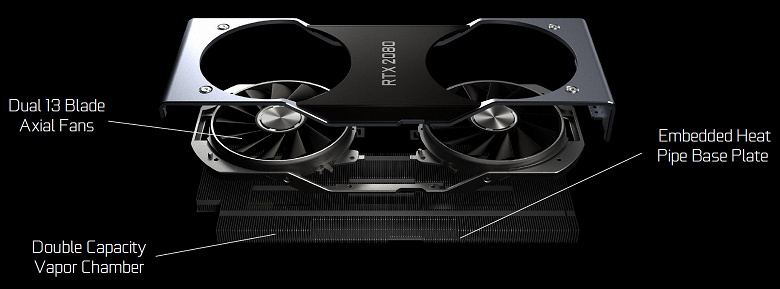

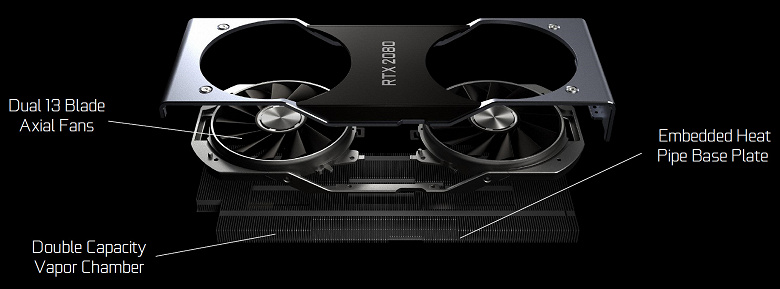

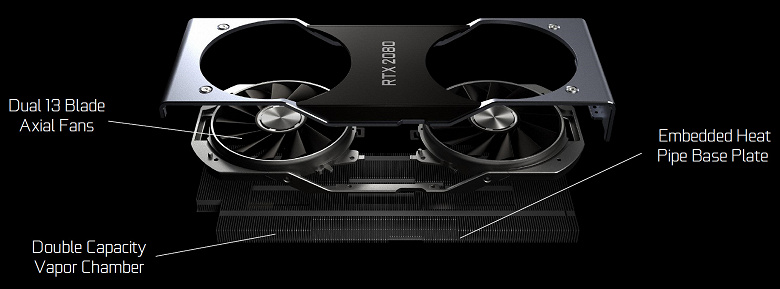

Как это стало обычным делом для нескольких семейств видеокарт Nvidia, линейка GeForce RTX предлагает специальные модели самой компании — так называемые Founders Edition. В этот раз при более высокой стоимости они обладают и более привлекательными характеристиками. Так, фабричный разгон у таких видеокарт есть изначально, а кроме этого, GeForce RTX 2080 Ti Founders Edition выглядят весьма солидно благодаря удачному дизайну и отличным материалам. Каждая видеокарта протестирована на стабильную работу и обеспечивается трехлетней гарантией.

Видеокарты GeForce RTX Founders Edition имеют кулер с испарительной камерой на всю длину печатной платы и два вентилятора для более эффективного охлаждения. Длинная испарительная камера и большой двухслотовый алюминиевый радиатор обеспечивают большую площадь рассеивания тепла. Вентиляторы отводят горячий воздух в разные стороны, и при этом работают они довольно тихо.

Система питания в GeForce RTX 2080 Ti Founders Edition также серьезно усилена: применяется 13-фазная схема iMon DrMOS (в GTX 1080 Ti Founders Edition была 7-фазная dual-FET), поддерживающая новую динамическую систему управления питанием с более тонким контролем, улучшающая разгонные возможности видеокарты, о которых мы еще поговорим далее. Для питания скоростной GDDR6-памяти установлена отдельная трехфазная схема.

Архитектурные особенности

Применяемая в старшей модели видеокарты GeForce RTX 2080 Ti модификация графического процессора TU102 по количеству блоков ровно вдвое больше, чем TU106, который появился в виде модели GeForce RTX 2070 чуть позднее. Самый же сложный TU102, применяемый в 2080 Ti, имеет площадь 754 мм² и 18,6 млрд транзисторов против 610 мм² и 15,3 млрд транзисторов у топового чипа семейства Pascal — GP100.

Примерно то же самое и с остальными новыми GPU, все они по сложности чипов как бы сдвинуты на шаг: TU102 соответствует TU100, TU104 по сложности похож на TU102, а TU106 — на TU104. Так как GPU усложнились, но техпроцессы применяются очень схожие, то и по площади новые чипы заметно увеличились. Посмотрим, за счет чего графические процессоры архитектуры Turing стали сложнее:

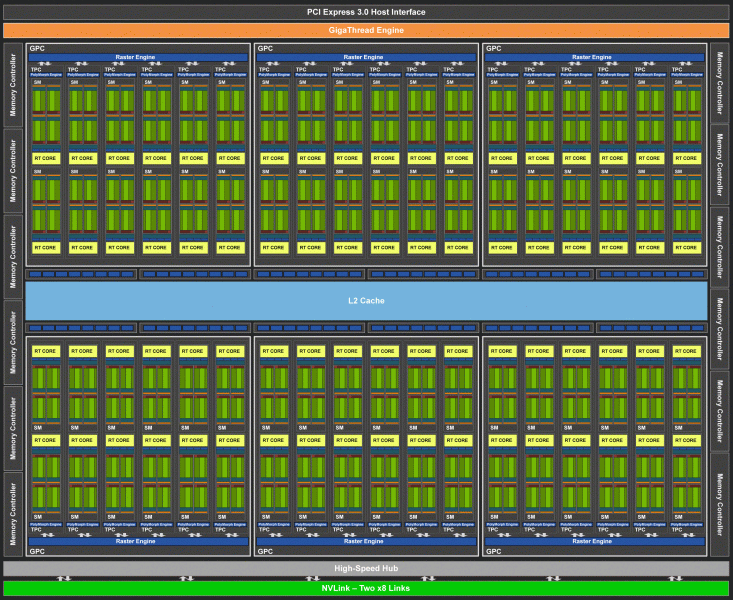

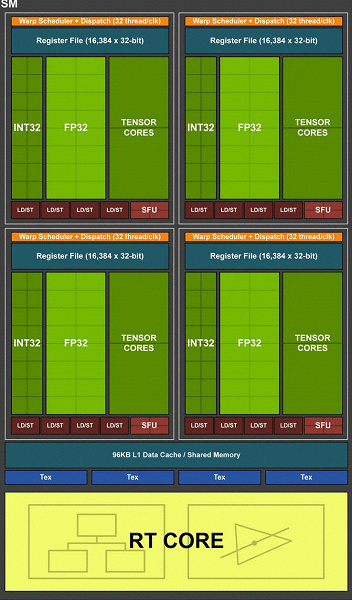

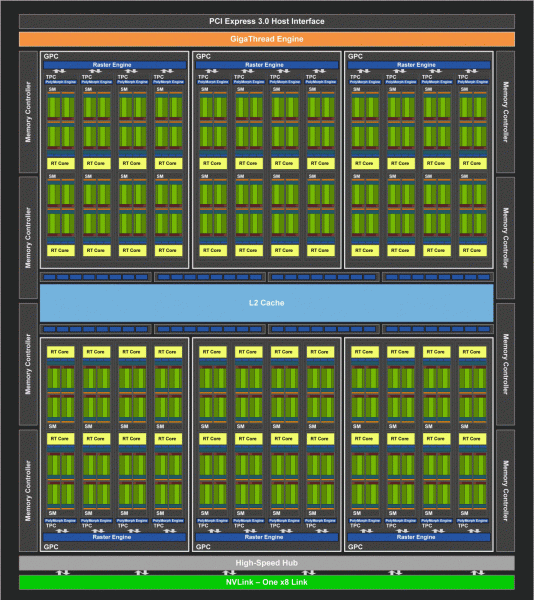

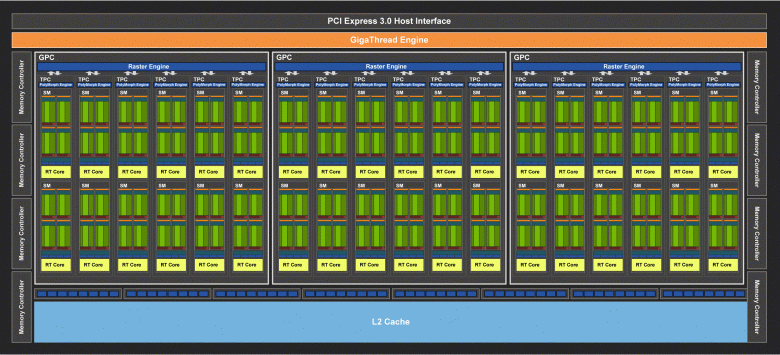

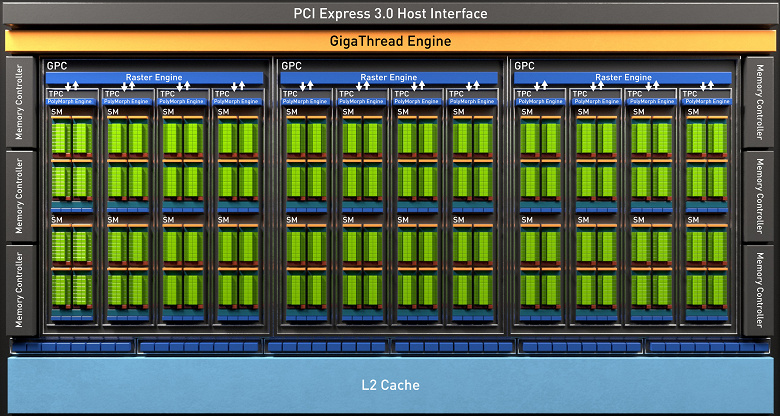

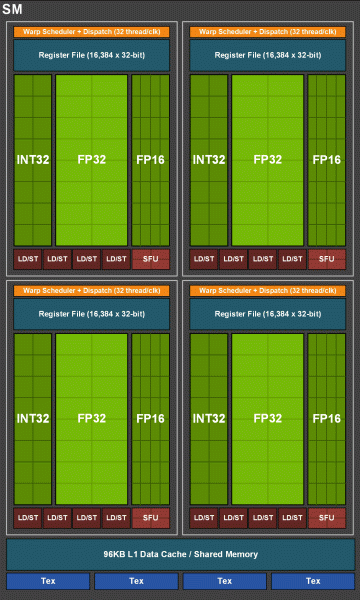

Полный чип TU102 включает шесть кластеров Graphics Processing Cluster (GPC), 36 кластеров Texture Processing Cluster (TPC) и 72 потоковых мультипроцессора Streaming Multiprocessor (SM). Каждый из кластеров GPC имеет собственный движок растеризации и шесть кластеров TPC, каждый из которых, в свою очередь, включает два мультипроцессора SM. Все SM содержат по 64 CUDA-ядра, по 8 тензорных ядер, по 4 текстурных блока, регистровый файл 256 КБ и 96 КБ конфигурируемого L1-кэша и разделяемой памяти. Для нужд аппаратной трассировки лучей каждый мультипроцессор SM имеет также и по одному RT-ядру.

Всего в полной версии TU102 получается 4608 CUDA-ядер, 72 RT-ядра, 576 тензорных ядер и 288 блоков TMU. Графический процессор общается с памятью при помощи 12 отдельных 32-битных контроллеров, что дает 384-битную шину в целом. К каждому контроллеру памяти привязаны по восемь блоков ROP и по 512 КБ кэш-памяти второго уровня. То есть всего в чипе 96 блоков ROP и 6 МБ L2-кэша.

По структуре мультипроцессоров SM новая архитектура Turing очень схожа с Volta, и количество ядер CUDA, блоков TMU и ROP по сравнению с Pascal выросло не слишком сильно — и это при таком усложнении и физическом увеличении чипа! Но это не удивительно, ведь основную сложность привнесли новые типы вычислительных блоков: тензорные ядра и ядра ускорения трассировки лучей.

Еще были усложнены сами CUDA-ядра, в которых появилась возможность одновременного исполнения целочисленных вычислений и операций с плавающей запятой, а также серьезно увеличен объем кэш-памяти. Об этих изменениях мы поговорим далее, а пока что отметим, что при проектировании семейства Turing разработчики намеренно перенесли фокус с производительности универсальных вычислительных блоков в пользу новых специализированных блоков.

Но не следует думать, что возможности CUDA-ядер остались неизменными, их тоже значительно улучшили. По сути, потоковый мультипроцессор Turing основан на варианте Volta, из которого исключена большая часть FP64-блоков (для операций с двойной точностью), но оставлена удвоенная производительность на такт для FP16-операций (также аналогично Volta). Блоков FP64 в TU102 оставлено 144 штуки (по два на SM), они нужны только для обеспечения совместимости. А вот вторая возможность позволит увеличить скорость и в приложениях, поддерживающих вычисления со сниженной точностью, вроде некоторых игр. Разработчики уверяют, что в значительной части игровых пиксельных шейдеров можно смело снизить точность с FP32 до FP16 при сохранении достаточного качества, что также принесет некоторый прирост производительности. Со всеми подробностями работы новых SM можно ознакомиться в обзоре архитектуры Volta.

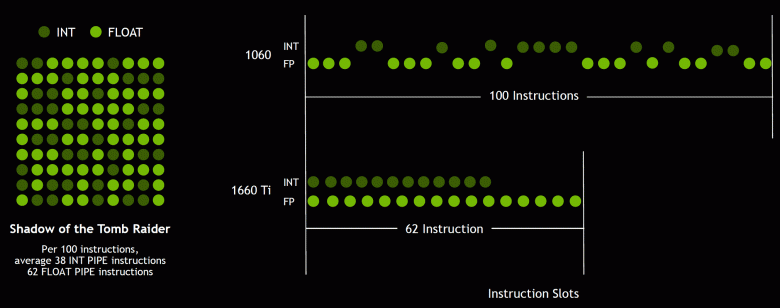

Одним из важнейших изменений потоковых мультипроцессоров является то, что в архитектуре Turing стало возможным одновременное выполнение целочисленных (INT32) команд вместе с операциями с плавающей запятой (FP32). Некоторые пишут, что в CUDA-ядрах «появились» блоки INT32, но это не совсем верно — они «появились» в составе ядер сразу, просто до архитектуры Volta одновременное исполнение целочисленных и FP-инструкций было невозможно, и эти операции запускались на выполнение по очереди. CUDA-ядра архитектуры Turing же схожи с ядрами Volta, которые позволяют исполнять INT32- и FP32-операции параллельно.

И так как игровые шейдеры, помимо операций с плавающей запятой, используют много дополнительных целочисленных операций (для адресации и выборки, специальных функций и т. п.), то это нововведение способно серьезно повысить производительность в играх. По оценкам компании Nvidia, в среднем на каждые 100 операций с плавающей запятой приходится около 36 целочисленных операций. Так что лишь это улучшение способно принести прирост скорости вычислений порядка 36%. Важно отметить, что это касается только эффективной производительности в типичных условиях, а на пиковых возможностях GPU не сказывается. То есть пусть теоретические цифры для Turing и не столь красивы, в реальности новые графические процессоры должны оказаться более эффективными.

Но почему, раз в среднем целочисленных операций лишь 36 на 100 FP-вычислений, количество блоков INT и FP одинаково? Скорее всего, это сделано для упрощения работы управляющей логики, а кроме этого, INT-блоки наверняка значительно проще FP, так что «лишнее» их количество вряд ли сильно повлияло на общую сложность GPU. Ну и задачи графических процессоров Nvidia давно не ограничиваются игровыми шейдерами, а в других применениях доля целочисленных операций вполне может быть и выше. Кстати, аналогично Volta повысился и темп выполнения инструкций для математических операций умножения-сложения с однократным округлением (fused multiply–add — FMA), требующих лишь четырех тактов по сравнению с шестью тактами на Pascal.

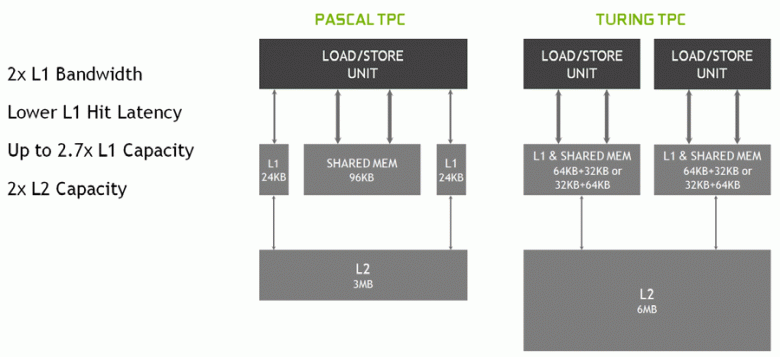

В новых мультипроцессорах SM была серьезно изменена и архитектура кэширования, для чего кэш первого уровня и разделяемая память были объединены (у Pascal они были раздельные). Shared-память ранее имела лучшие характеристики по пропускной способности и задержкам, а теперь пропускная способность L1-кэша выросла вдвое, снизились задержки доступа к нему вместе с одновременным увеличением емкости кэша. В новом GPU можно изменять соотношение объема L1-кэша и разделяемой памяти, выбирая из нескольких возможных конфигураций.

Кроме этого, в каждом разделе мультипроцессора SM появился L0-кэш для инструкций вместо общего буфера, а каждый кластер TPC в чипах архитектуры Turing теперь имеет вдвое больше кэш-памяти второго уровня. То есть общий объем L2-кэша вырос до 6 МБ для TU102 (у TU104 и TU106 его поменьше — 4 МБ).

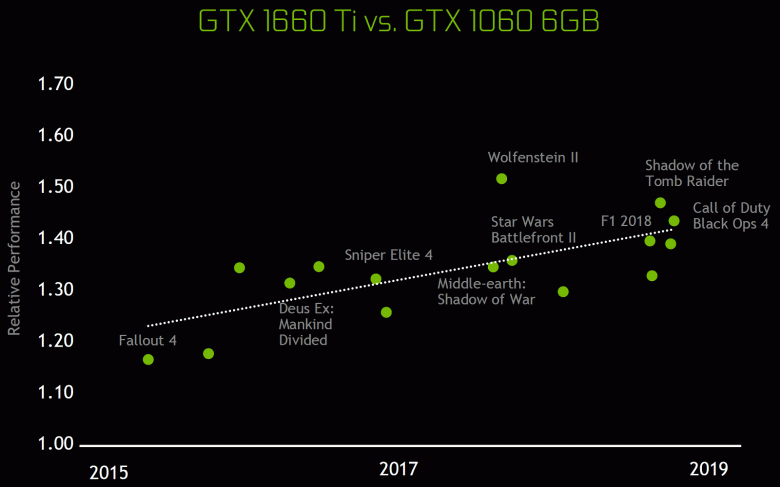

Эти архитектурные изменения привели к 50%-ному улучшению производительности шейдерных процессоров при равной тактовой частоте в таких играх, как Sniper Elite 4, Deus Ex, Rise of the Tomb Raider и других. Но это не значит, что общий рост частоты кадров будет равен 50%, так как общая производительность рендеринга в играх далеко не всегда ограничена именно скоростью вычисления шейдеров.

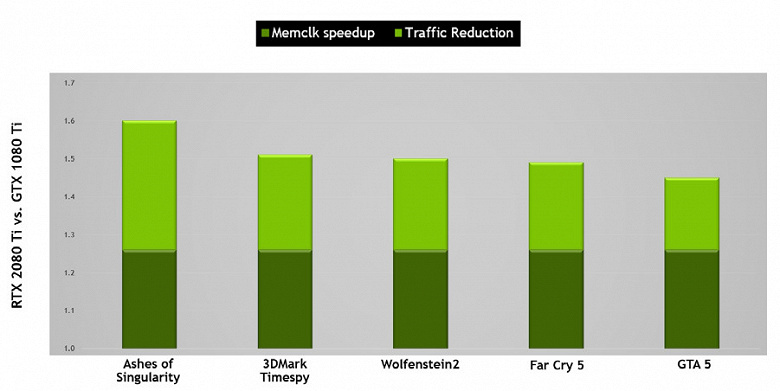

Также были улучшены технологии сжатия информации без потерь, экономящие видеопамять и ее пропускную способность. Архитектура Turing поддерживает новые техники сжатия — по данным Nvidia, до 50% более эффективные по сравнению с алгоритмами в семействе чипов Pascal. Вместе с применением нового типа памяти GDDR6 это дает приличный прирост эффективной ПСП, так что новые решения не должны быть ограничены возможностями памяти. А при увеличении разрешения рендеринга и повышении сложности шейдеров ПСП играет важнейшую роль в обеспечении общей высокой производительности.

К слову, о памяти. Инженеры Nvidia работали совместно с производителями для обеспечения поддержки нового типа памяти — GDDR6, и все новое семейство GeForce RTX поддерживает микросхемы этого типа, имеющие пропускную способность в 14 Гбит/с и при этом на 20% более энергоэффективные по сравнению с применяемой в топовых Pascal GDDR5X-памятью. Топовый чип TU102 имеет 384-битную шину памяти (12 штук 32-битных контроллеров), но так как один из них отключен в GeForce RTX 2080 Ti, то шина памяти у него 352-битная, и на топовую карту семейства установлено 11, а не 12 ГБ.

Сама по себе GDDR6 хоть и является совершенно новым типом памяти, но слабо отличается от уже использовавшейся ранее GDDR5X. Основное ее отличие — в еще более высокой тактовой частоте при том же напряжении в 1,35 В. А от GDDR5 новый тип отличается тем, что имеет два независимых 16-битных канала с собственными шинами команд и данных — в отличие от единого 32-битного интерфейса GDDR5 и не полностью независимых каналов в GDDR5X. Это позволяет оптимизировать передачу данных, а более узкая 16-битная шина работает эффективнее.

Характеристики GDDR6 обеспечивают высокую пропускную способность памяти, которая стала значительно выше, чем была у предыдущего поколения GPU, поддерживающего типы памяти GDDR5 и GDDR5X. Рассматриваемая сегодня GeForce RTX 2080 Ti имеет ПСП на уровне 616 ГБ/с, что выше и чем у предшественников, и чем у конкурирующей видеокарты, использующей дорогую память стандарта HBM2. В будущем характеристики памяти GDDR6 будут улучшаться, сейчас ее выпускают компании Micron (скорость от 10 до 14 Гбит/с) и Samsung (14 и 16 Гбит/с).

Другие нововведения

Добавим немного информации о других нововведениях Turing, которые будут полезны и для старых, и для новых игр. К примеру, по некоторым фичам (feature level) из Direct3D 12 чипы Pascal отставали от решений AMD и даже Intel! В частности, это касается таких возможностей, как Constant Buffer Views, Unordered Access Views и Resource Heap (возможности, облегчающие работу программистов, упрощая доступ к различным ресурсам). Так вот, по этим возможностям Direct3D feature level новые GPU компании Nvidia теперь практически не отстают от конкурентов, поддерживая уровень Tier 3 для Constant Buffer Views и Unordered Access Views и Tier 2 для resource heap.

Единственная возможность D3D12, которая есть у конкурентов, но не поддерживается в Turing — PSSpecifiedStencilRefSupported: возможность вывести из пиксельного шейдера референсное значение стенсиля, иначе его можно установить только глобально для всего вызова функции отрисовки. В некоторых старых играх стенсиль использовался для отсечения источников освещения в различных регионах экрана, и эта возможность была полезна для занесения в стенсиль маски с несколькими разными значениями, чтобы каждому источнику света отрисовываться в своем проходе со стенсил-тестом. Без PSSpecifiedStencilRefSupported эту маску приходится рисовать в несколько проходов, а так можно сделать один, вычисляя значение стенсиля непосредственно в пиксельном шейдере. Вроде бы штука полезная, но в реальности не сильно важна — проходы эти несложные, и заполнение стенсиля в несколько проходов мало на что влияет при современных GPU.

Зато с остальным все в порядке. Появилась поддержка удвоенного темпа исполнения инструкций с плавающей запятой, и в том числе в Shader Model 6.2 — новой шейдерной модели DirectX 12, которая включает нативную поддержку FP16, когда вычисления производятся именно в 16-битной точности и драйвер не имеет права использовать FP32. Предыдущие GPU игнорировали установку min precision FP16, используя FP32, когда им вздумается, а в SM 6.2 шейдер может потребовать использование именно 16-битного формата.

Кроме этого, было серьезно улучшено еще одно больное место чипов Nvidia — асинхронное исполнение шейдеров, высокой эффективностью которого отличаются решения AMD. Async compute уже неплохо работал в последних чипах семейства Pascal, но в Turing эта возможность была еще улучшена. Асинхронные вычисления в новых GPU полностью переработаны, и на одном и том же шейдерном мультипроцессоре SM могут запускать и графические, и вычислительные шейдеры, как и чипы AMD.

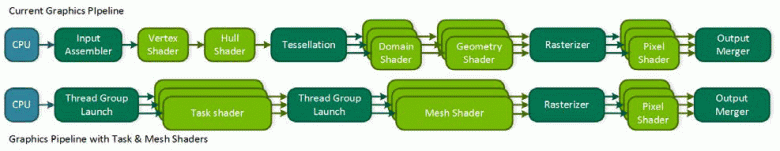

Но и это еще не все, чем может похвастать Turing. Многие изменения в этой архитектуре нацелены на будущее. Так, Nvidia предлагает метод, позволяющий значительно снизить зависимость от мощности CPU и одновременно с этим во много раз увеличить количество объектов в сцене. Бич API/CPU overhead давно преследует ПК-игры, и хотя он частично решался в DirectX 11 (в меньшей степени) и DirectX 12 (в несколько большей, но все равно не полностью), радикально ничего не изменилось — каждый объект сцены требует нескольких вызовов функций отрисовки (draw calls), каждый из которых требует обработки на CPU, что не дает GPU показать все свои возможности.

Слишком многое сейчас зависит от производительности центрального процессора, и даже современные многопоточные модели не всегда справляются. Кроме этого, если минимизировать «вмешательство» CPU в процесс рендеринга, то можно открыть множество новых возможностей. Конкурент Nvidia при анонсе своего семейства Vega предложил возможное решение проблем — primivtive shaders, но дело не пошло дальше заявлений. Turing предлагает аналогичное решение под названием mesh shaders — это целая новая шейдерная модель, которая ответственна сразу за всю работу над геометрией, вершинами, тесселяцией и т. д.

Mesh shading заменяет вершинные и геометрические шейдеры и тесселяцию, а весь привычный вершинный конвейер заменяется аналогом вычислительных шейдеров для геометрии, которыми можно делать все, что нужно разработчику: трансформировать вершины, создавать их или убирать, используя вершинные буферы в своих целях как угодно, создавая геометрию прямо на GPU и отправляя ее на растеризацию. Естественно, такое решение может сильно снизить зависимость от мощности CPU при рендеринге сложных сцен и позволит создавать богатые виртуальные миры с огромным количеством уникальных объектов. Такой метод также позволит использовать более эффективное отбрасывание невидимой геометрии, продвинутые техники уровня детализации (LOD — level of detail) и даже процедурную генерацию геометрии.

Но столь радикальный подход требует поддержки от API — наверное, поэтому у конкурента дело дальше заявлений не пошло. Вероятно, в Microsoft работают над добавлением этой возможности, раз она востребована уже двумя основными производителями GPU, и в какой-то из будущих версий DirectX она появится. Ну а пока что ее можно использовать в OpenGL и Vulkan через расширения, а в DirectX 12 — при помощи специализированного NVAPI, который как раз и создан для внедрения возможностей новых GPU, еще не поддерживаемых в общепринятых API. Но так как это не универсальный для всех производителей GPU метод, то широкой поддержки mesh shaders в играх до обновления популярных графических API, скорее всего, не будет.

Еще одна интереснейшая возможность Turing называется Variable Rate Shading (VRS) — это шейдинг с переменным количеством сэмплов. Эта новая возможность дает разработчику контроль над тем, сколько выборок использовать в случае каждого из тайлов буфера размером 4×4 пикселя. То есть для каждого тайла изображения из 16 пикселей можно выбрать свое качество на этапе закраски пикселя — как меньшее, так и большее. Важно, что это не касается геометрии, так как буфер глубины и все остальное остается в полном разрешении.

Зачем это нужно? В кадре всегда есть участки, на которых легко можно понизить количество сэмплов закраски практически без потерь в качестве — к примеру, это части изображения, замыленные постэффектами типа Motion Blur или Depth of Field. А на каких-то участках можно, наоборот, увеличить качество закраски. И разработчик сможет задавать достаточное, по его мнению, качество шейдинга для разных участков кадра, что увеличит производительность и гибкость. Сейчас для подобных задач применяют так называемый checkerboard rendering, но он не универсален и ухудшает качество закраски для всего кадра, а с VRS можно делать это максимально тонко и точно.

Можно упрощать шейдинг тайлов в несколько раз, чуть ли не одну выборку для блока в 4×4 пикселя (такая возможность не показана на картинке, но она есть), а буфер глубины остается в полном разрешении, и даже при таком низком качестве шейдинга границы полигонов будут сохраняться в полном качестве, а не один на 16. К примеру, на картинке выше самые смазанные участки дороги рендерятся с экономией ресурсов вчетверо, остальные — вдвое, и лишь самые важные отрисовываются с максимальным качеством закраски. Так и в других случаях можно отрисовывать с меньшим качеством низкодетализированные поверхности и быстро движущиеся объекты, а в приложениях виртуальной реальности снижать качество закраски на периферии.

Кроме оптимизации производительности, эта технология дает и некоторые неочевидные сходу возможности, вроде почти бесплатного сглаживания геометрии. Для этого нужно отрисовывать кадр в вчетверо большем разрешении (как бы суперсэмплинг 2×2), но включить shading rate на 2×2 по всей сцене, что убирает стоимость вчетверо большей работы по закраске, но оставляет сглаживание геометрии в полном разрешении. Таким образом получается, что шейдеры исполняются лишь один раз на пиксель, но сглаживание получается как 4х MSAA практически бесплатно, поскольку основная работа GPU заключается именно в шейдинге. И это лишь один из вариантов использования VRS, наверняка программисты придумают и другие.

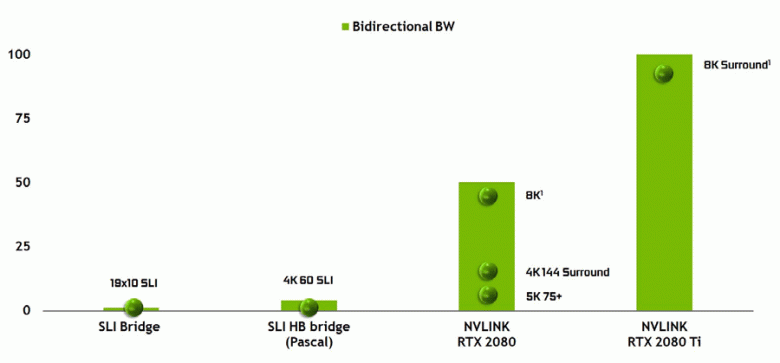

Нельзя не отметить и появление высокопроизводительного интерфейса NVLink второй версии, который уже используется в ускорителях высокопроизводительных вычислений Tesla. Топовый чип TU102 имеет два порта NVLink второго поколения, имеющие общую пропускную способность в 100 ГБ/с (к слову, в TU104 один такой порт, а TU106 лишен поддержки NVLink вовсе). Новый интерфейс заменяет разъемы SLI, а пропускной способности даже одного порта хватит для передачи кадрового буфера с разрешением 8К в режиме многочипового рендеринга AFR от одного GPU к другому, а передача буфера 4K-разрешения доступна на скоростях до 144 Гц. Два порта расширяют возможности SLI сразу до нескольких мониторов с разрешением 8K.

Такая высокая скорость передачи данных позволяет использовать локальную видеопамять соседнего GPU (присоединенного по NVLink, разумеется) практически как свою собственную, и это делается автоматически, без необходимости сложного программирования. Это будет весьма полезно в неграфических применениях и уже применяется в профессиональных приложениях с поддержкой аппаратной трассировки лучей (две видеокарты Quadro c 48 ГБ памяти каждая способны работать над сценой практически как единый GPU с 96 ГБ памяти, для чего ранее приходилось делать копии сцены в памяти обоих GPU), но в будущем это станет полезно и при более сложном взаимодействии многочиповых конфигураций в рамках возможностей DirectX 12. В отличие от SLI, быстрый обмен информацией по NVLink позволит организовать иные формы работы над кадром, чем AFR со всеми его недостатками.

Аппаратная поддержка трассировки лучей

Как стало известно из анонса архитектуры Turing и профессиональных решений линейки Quadro RTX на конференции SIGGraph, новые графические процессоры компании Nvidia, кроме ранее известных блоков, впервые включают также и специализированные RT-ядра, предназначенные для аппаратного ускорения трассировки лучей. Пожалуй, большая часть дополнительных транзисторов в новых GPU принадлежит именно к этим блокам аппаратной трассировки лучей, ведь количество традиционных исполнительных блоков выросло не слишком сильно, хотя и тензорные ядра немало повлияли на увеличение сложности GPU.

Nvidia сделала ставку на аппаратное ускорение трассировки при помощи специализированных блоков, и это большой шаг вперед для качественной графики в реальном времени. Мы уже публиковали большую подробную статью о трассировке лучей в реальном времени, гибридном подходе и его преимуществах, которые проявятся уже в ближайшее время. Настоятельно советуем ознакомиться, в этом материале мы расскажем о трассировке лучей лишь очень кратко.

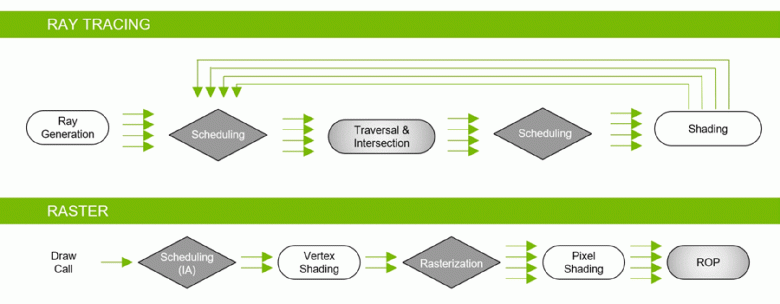

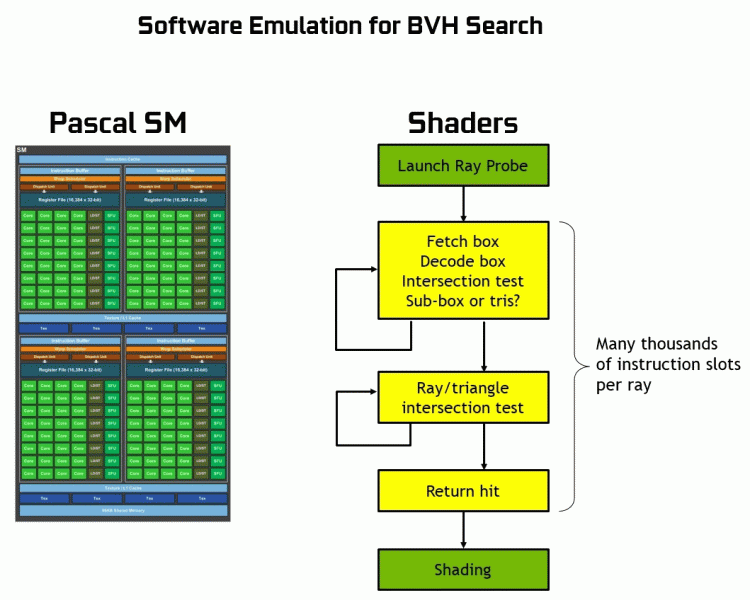

Благодаря семейству GeForce RTX уже сейчас можно использовать трассировку для некоторых эффектов: качественных мягких теней (реализовано в игре Shadow of the Tomb Raider), глобального освещения (ожидается в Metro Exodus и Enlisted), реалистичных отражений (будет в Battlefield V), а также сразу нескольких эффектов одновременно (показано на примерах Assetto Corsa Competizione, Atomic Heart и Control). При этом для GPU, не имеющих аппаратных RT-ядер в своем составе, можно использовать или привычные методы растеризации, или трассировку на вычислительных шейдерах, если это будет не слишком медленно. Вот так по-разному обрабатывают трассировку лучей архитектуры Pascal и Turing:

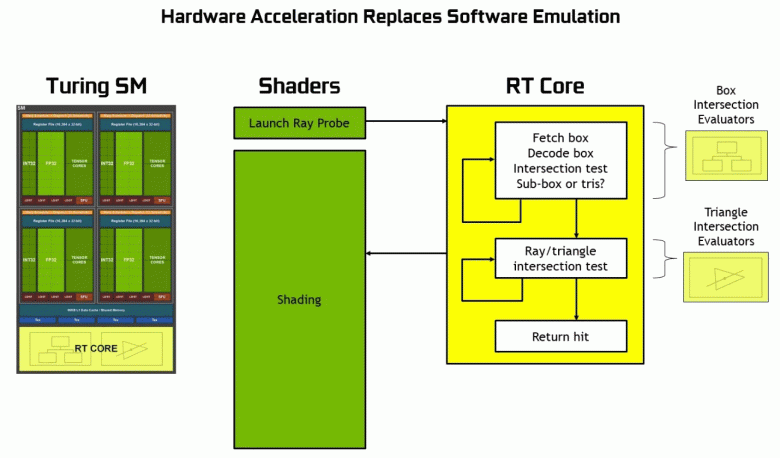

Как видите, RT-ядро полностью принимает на себя работу по определению пересечений лучей с треугольниками. Скорее всего, графические решения без RT-ядер в своем составе будут смотреться не слишком сильно в проектах с применением трассировки лучей, ведь эти ядра специализируются исключительно на расчетах пересечения луча с треугольниками и ограничивающими объемами (BVH), оптимизирующими процесс и важнейшими для ускорения процесса трассировки.

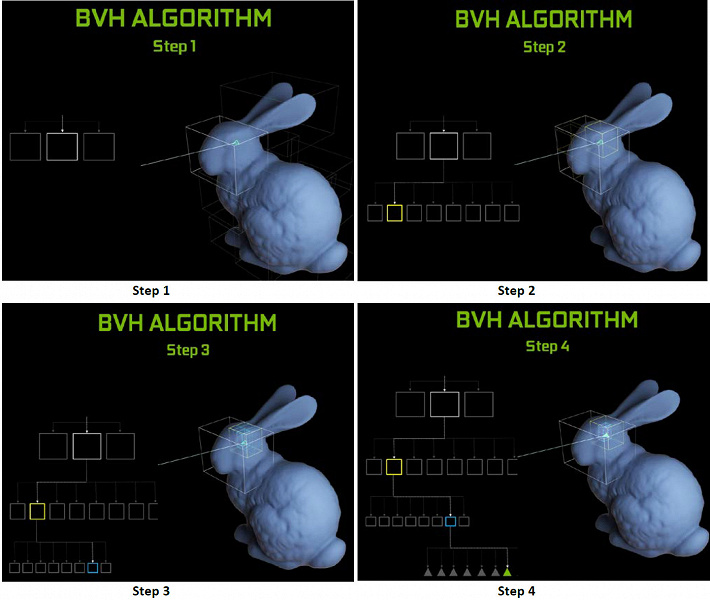

Каждый мультипроцессор в чипах Turing содержит RT-ядро, выполняющее поиск пересечений между лучами и полигонами, а чтобы не перебирать все геометрические примитивы, в Turing используется распространенный алгоритм оптимизации — иерархия ограничивающих объемов (Bounding Volume Hierarchy — BVH). Каждый полигон сцены принадлежит к одному из объемов (коробок), помогающих наиболее быстро определить точку пересечения луча с геометрическим примитивом. При работе BVH нужно рекурсивно обойти древовидную структуру таких объемов. Сложности могут возникнуть разве что для динамически изменяемой геометрии, когда придется менять и структуру BVH.

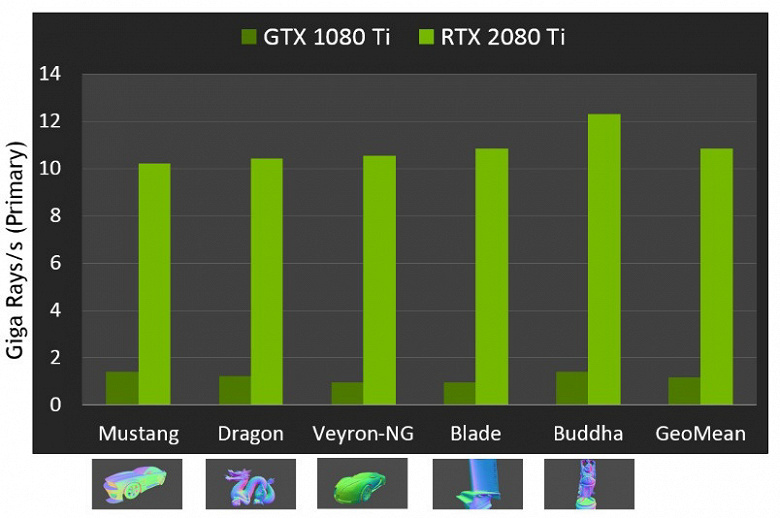

Что касается производительности новых GPU при трассировке лучей, то публике назвали цифру в 10 гигалучей в секунду для топового решения GeForce RTX 2080 Ti. Не очень понятно, много это или мало, да и оценивать производительность в количестве обсчитываемых лучей в секунду непросто, так как скорость трассировки очень сильно зависит от сложности сцены и когерентности лучей и может отличаться в десяток раз и более. В частности, слабо когерентные лучи при обсчете отражений и преломлений требуют большего времени для расчета по сравнению с когерентными основными лучами. Так что показатели эти чисто теоретические, а сравнивать разные решения нужно в реальных сценах при одинаковых условиях.

Но Nvidia сравнила новые GPU с предыдущим поколением, и в теории они оказались до 10 раз быстрее в задачах трассировки. В реальности же разница между RTX 2080 Ti и GTX 1080 Ti будет, скорее, ближе к 4-6-кратной. Но даже это — просто отличный результат, недостижимый без применения специализированных RT-ядер и ускоряющих структур типа BVH. Так как бо́льшая часть работы при трассировке выполняется на выделенных RT-ядрах, а не CUDA-ядрах, то снижение производительности при гибридном рендеринге будет заметно ниже, чем у Pascal.

Мы уже показывали вам первые демонстрационные программы с применением трассировки лучей. Некоторые из них были более зрелищными и качественными, другие впечатляли меньше. Но о потенциальных возможностях трассировки лучей не стоит судить по первым выпущенным демонстрациям, в которых намеренно выпячивают на первый план именно эти эффекты. Картинка с трассировкой лучей всегда реалистичнее в целом, но на данном этапе массы еще готовы мириться с артефактами при расчете отражений и глобального затенения в экранном пространстве, а также другими хаками растеризации.

Игровым разработчикам очень нравится трассировка, их аппетиты растут на глазах. Создатели игры Metro Exodus сначала планировали добавить в игру лишь расчет Ambient Occlusion, добавляющий теней в основном в углах между геометрией, но затем они решили внедрить уже полноценный расчет глобального освещения GI, который выглядит впечатляюще.

Кто-то скажет, что ровно так же можно предварительно рассчитать GI и/или тени и «запечь» информацию об освещении и тенях в специальные лайтмапы, но для больших локаций с динамическим изменением погодных условий и времени суток сделать это просто невозможно! Хотя растеризация при помощи многочисленных хитрых хаков и трюков действительно добилась отличных результатов, когда во многих случаях картинка выглядит достаточно реалистично для большинства людей, все же в некоторых случаях отрисовать корректные отражения и тени при растеризации невозможно физически.

Самый явный пример — отражения объектов, которые находятся вне сцены — типичными методами отрисовки отражений без трассировки лучей отрисовать их невозможно в принципе. Также не получится сделать реалистичные мягкие тени и корректно рассчитать освещение от больших по размеру источников света (площадные источники света — area lights). Для этого пользуются разными хитростями, вроде расстановки вручную большого количества точечных источников света и фейкового размытия границ теней, но это не универсальный подход, он работает только в определенных условиях и требует дополнительной работы и внимания от разработчиков. Для качественного же скачка в возможностях и улучшении качества картинки переход к гибридному рендерингу и трассировке лучей просто необходим.

Трассировку лучей можно применять дозированно, для отрисовки определенных эффектов, которые сложно сделать растеризацией. Точно такой же путь в свое время проходила киноиндустрия, в которой в конце прошлого века применялся гибридный рендеринг с одновременной растеризацией и трассировкой. А еще через 10 лет все в кино постепенно перешли к полноценной трассировке лучей. То же самое будет и в играх, этот шаг с относительно медленной трассировкой и гибридным рендерингом невозможно пропустить, так как он дает возможность подготовиться к трассировке всего и вся.

Тем более, что во многих хаках растеризации уже и так используются схожие с трассировкой методы (к примеру, можно взять самые продвинутые методы имитации глобального затенения и освещения), поэтому более активное использование трассировки в играх — лишь дело времени. Заодно она позволяет упростить работу художников по подготовке контента, избавляя от необходимости расставлять фейковые источники света для имитации глобального освещения и от некорректных отражений, которые с трассировкой будут выглядеть естественно.

Переход к полной трассировке лучей (path tracing) в киноиндустрии привел к увеличению времени работы художников непосредственно над контентом (моделированием, текстурированием, анимацией), а не над тем, как сделать неидеальные методы растеризации реалистичными. К примеру, сейчас очень много времени уходит на рассатнвоку источников света, предварительный расчет освещения и «запекание» его в статические карты освещения. При полноценной трассировке это будет не нужно вовсе, и даже сейчас подготовка карт освещения на GPU вместо CPU даст ускорение этого процесса. То есть переход на трассировку обеспечит не только улучшение картинки, но и скачок в качестве самого контента.

В большинстве игр возможности GeForce RTX будут использоваться через DirectX Raytracing (DXR) — универсальный API Microsoft. Но для GPU без аппаратной/программной поддержки трассировки лучей также можно использовать D3D12 Raytracing Fallback Layer — библиотеку, которая эмулирует DXR при помощи вычислительных шейдеров. Эта библиотека имеет схожий, хоть и отличающийся интерфейс по сравнению с DXR, и это несколько разные вещи. DXR — это API, реализуемый непосредственно в драйвере GPU, он может быть реализован как аппаратно, так и полностью программно, на тех же вычислительных шейдерах. Но это будет разный код с разной производительностью. Вообще, изначально Nvidia не планировала поддерживать DXR на своих решениях до архитектуры Volta, но теперь и видеокарты семейства Pascal работают через DXR API, а не только через D3D12 Raytracing Fallback Layer.

Тензорные ядра для интеллекта

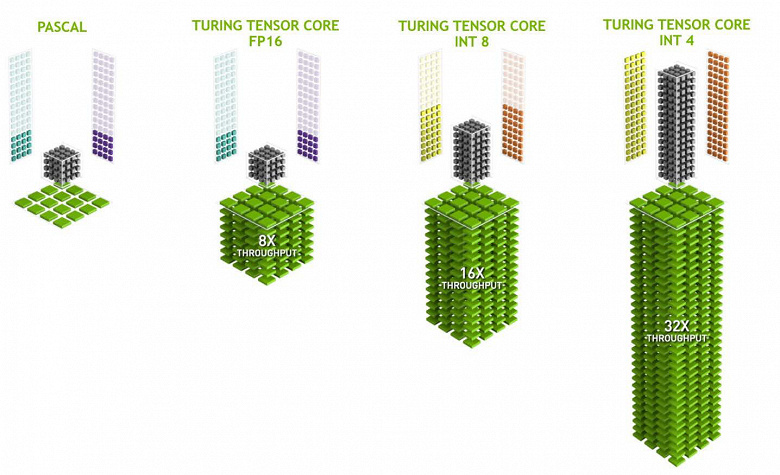

Потребности в производительности для работы нейросетей все большего размера и сложности постоянно растут, и в архитектуре Volta добавили новый тип специализированных вычислительных ядер — тензорные ядра. Они помогают получить многократный рост производительности по обучению и инференсу больших нейронных сетей, используемых в задачах искусственного интеллекта. Операции матричного перемножения лежат в основе обучения и инференса (выводы на основе уже обученной нейросети) нейронных сетей, они используются для умножения больших матриц входных данных и весов в связанных слоях сети.

Тензорные ядра специализируются на выполнении конкретно таких перемножений, они значительно проще универсальных ядер и способны серьезно увеличить производительность таких вычислений при сохранении сравнительно небольшой сложности в транзисторах и площади. Мы подробно писали обо всем этом в обзоре вычислительной архитектуры Volta. Кроме перемножения матриц FP16, тензорные ядра в Turing умеют оперировать и с целыми числами в форматах INT8 и INT4 — с еще большей производительностью. Такая точность подходит для применения в некоторых нейросетях, не требующих высокой точности представления данных, зато скорость расчетов возрастает еще вдвое и вчетверо. Пока что экспериментов с использованием пониженной точности не очень много, но потенциал ускорения в 2-4 раза может открыть новые возможности.

Важно, что эти операции можно выполнять параллельно с CUDA-ядрами, только FP16-операции в последних использует то же самое «железо», что и тензорные ядра, поэтому FP16 нельзя исполнять параллельно на CUDA-ядрах и на тензорных. Тензорные ядра могут исполнять или тензорные инструкции, или FP16-инструкции, и в этом случае их возможности используются не полностью. Скажем, сниженная точность FP16 дает прирост в темпе вдвое по сравнению с FP32, а использование тензорной математики — в 8 раз. Но тензорные ядра — специализированные, они не очень хорошо подходят для произвольных вычислений: умеют выполнять только матричное перемножение в фиксированной форме, которое используется в нейронных сетях, но не в обычных графических применениях. Впрочем, вполне возможно, что игровые разработчики придумают и другие применения тензорам, не связанные с нейросетями.

Но и задачи с применением искусственного интеллекта (глубокое обучение) уже сейчас применяют широко, в том числе они появятся и в играх. Главное, для чего потенциально нужны тензорные ядра в GeForce RTX — для помощи все той же трассировке лучей. На начальной стадии применения аппаратной трассировки производительности хватает только для сравнительно малого количества рассчитываемых лучей на каждый пиксель, а малое количество рассчитываемых сэмплов дает весьма «шумную» картинку, которую приходится обрабатывать дополнительно (подробности читайте в нашей статье о трассировке).

В первых игровых проектах обычно применяется расчет от 1 до 3-4 лучей на пиксель, в зависимости от задачи и алгоритма. К примеру, в ожидаемой в следующем году игре Metro Exodus для расчета глобального освещения с применением трассировки используется по три луча на пиксель с расчетом одного отражения, и без дополнительной фильтрации и шумопонижения результат к применению не слишком пригоден.

Для решения этой проблемы можно использовать различные фильтры шумопонижения, улучшающие результат без необходимости увеличения количества выборок (лучей). Шумодавы очень эффективно устраняют неидеальность результата трассировки со сравнительно малым количеством выборок, и результат их работы зачастую почти не отличить от изображения, полученного с помощью в разы большего количества выборок. На данный момент в Nvidia используют различные шумодавы, в том числе основанные на работе нейросетей, которые как раз и могут быть ускорены на тензорных ядрах.

В будущем такие методы с применением ИИ будут улучшаться, они способны полностью заменить все остальные. Главное, что нужно понять: на текущем этапе применениям трассировки лучей без фильтров шумоподавления не обойтись, именно поэтому тензорные ядра обязательно нужны в помощь RT-ядрам. В играх нынешние реализации пока что не используют тензорные ядра, у Nvidia хоть и есть реализация шумоподавления при трассировке, которая использует тензорные ядра — в OptiX, но из-за скорости работы алгоритма его пока что не получается применить в играх. Но его наверняка можно упростить, чтобы использовать в том числе и в игровых проектах.

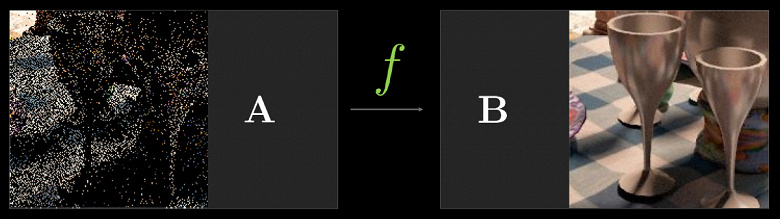

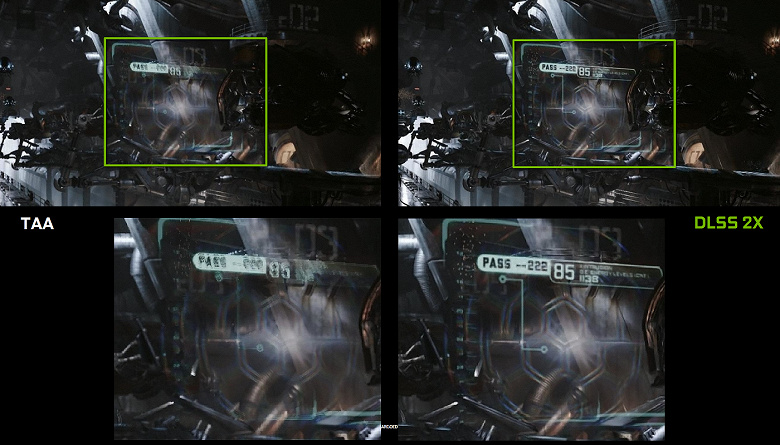

Однако использовать искусственный интеллект (ИИ) и тензорные ядра можно не только для этой задачи. Nvidia уже показывала новый метод полноэкранного сглаживания — DLSS (Deep Learning Super Sampling). Его правильнее назвать улучшителем качества картинки, потому что это не привычное сглаживание, а технология, использующая искусственный интеллект для улучшения качества отрисовки аналогично сглаживанию. Для работы DLSS нейросеть сначала «тренируют» в офлайне на тысячах изображений, полученных с применением суперсэмплинга с количеством выборок 64 штуки, а затем уже в реальном времени на тензорных ядрах исполняются вычисления (инференс), которые «дорисовывают» изображение.

То есть нейросеть на примере тысяч хорошо сглаженных изображений из конкретной игры учат «додумывать» пиксели, делая из грубой картинки сглаженную, и она затем успешно делает это уже для любого изображения из той же игры. Такой метод работает значительно быстрее любого традиционного, да еще и с лучшим качеством — в частности, вдвое быстрее, чем GPU предыдущего поколения с использованием традиционных методов сглаживания типа TAA. У DLSS пока что есть два режима: обычный DLSS и DLSS 2x. Во втором случае рендеринг осуществляется в полном разрешении, а в упрощенном DLSS используется сниженное разрешение рендеринга, но обученная нейросеть дорисовывает кадр до полного разрешения экрана. В обоих случаях DLSS дает более высокое качество и стабильность по сравнению с TAA.

К сожалению, у DLSS есть один немаловажный недостаток: для внедрения этой технологии нужна поддержка со стороны разработчиков, так как для работы метода требуются данные из буфера с векторами движения. Но таких проектов уже довольно много, на сегодняшний день есть 25 поддерживающих эту технологию игр, включая такие известные, как Final Fantasy XV, Hitman 2, PlayerUnknown’s Battlegrounds, Shadow of the Tomb Raider, Hellblade: Senua’s Sacrifice и другие.

Но и DLSS — это еще не все, для чего можно применять нейросети. Все зависит от разработчика, он может использовать мощь тензорных ядер для более «умного» игрового ИИ, улучшенной анимации (такие методы уже есть), да много чего еще можно придумать. Главное, что возможности применения нейросетей фактически безграничны, мы просто еще даже не догадываемся о том, что́ можно сделать с их помощью. Раньше производительности было слишком мало для того, чтобы применять нейросети массово и активно, а теперь, с появлением тензорных ядер в простых игровых видеокартах (пусть пока только дорогих) и возможностью их использования при помощи специального API и фреймворка Nvidia NGX (Neural Graphics Framework), это становится всего лишь делом времени.

Автоматизация разгона

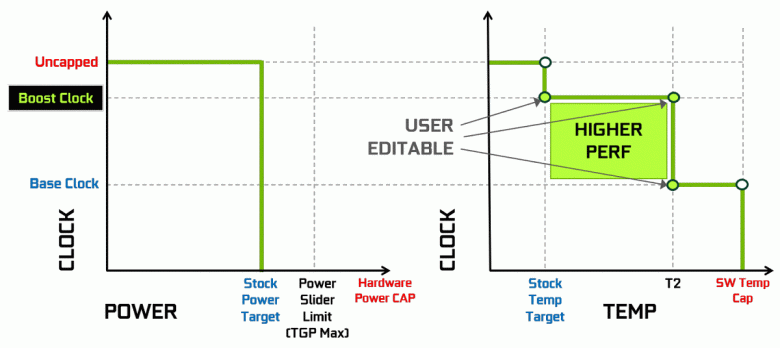

Видеокарты Nvidia давно используют динамическое повышение тактовой частоты в зависимости от загрузки GPU, питания и температуры. Этот динамический разгон контролируется алгоритмом GPU Boost, постоянно отслеживающим данные от встроенных сенсоров и меняющим характеристики GPU по частоте и напряжению питания в попытках выжать максимум возможной производительности из каждого приложения. Четвертое поколение GPU Boost добавляет возможность ручного управления алгоритмом работы разгона GPU Boost.

Алгоритм работы в GPU Boost 3.0 был полностью зашит в драйвере, и пользователь никак не мог повлиять на него. А в GPU Boost 4.0 ввели возможность ручного изменения кривых для увеличения производительности. К линии температур можно добавить несколько точек, и вместо прямой теперь используется ступенчатая линия, а частота не сбрасывается до базовой сразу же, обеспечивая бо́льшую производительность при определенных температурах. Пользователь может изменить кривую самостоятельно для достижения более высокой производительности.

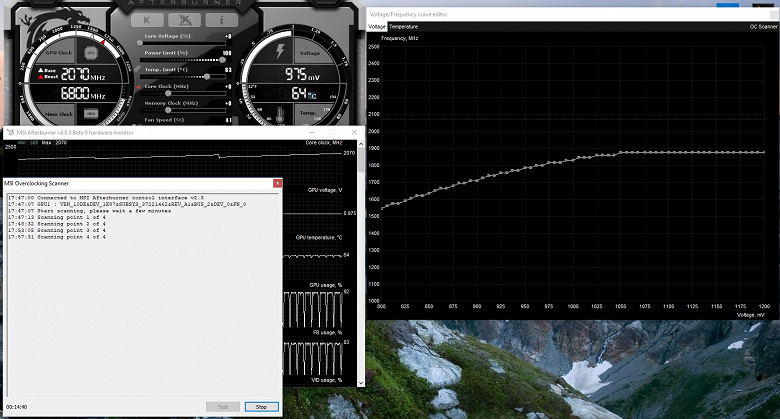

Кроме этого, впервые появилась такая новая возможность, как автоматизированный разгон. Это энтузиасты умеют разгонять видеокарты, но к ним относятся далеко не все пользователи, и не все могут или хотят заниматься ручным подбором характеристик GPU для повышения производительности. В Nvidia решили облегчить задачу для обычных пользователей, позволив каждому разогнать свои GPU буквально нажатием одной кнопки — при помощи Nvidia Scanner.

Nvidia Scanner запускает отдельный поток для тестирования возможностей GPU, который использует математический алгоритм, автоматически определяющий ошибки в расчетах и стабильность работы видеочипа на разных частотах. То есть то, что обычно делается энтузиастом на протяжении нескольких часов, с зависаниями, перезагрузками и прочими фокусами, теперь может сделать автоматизированный алгоритм, требующий на перебор всех возможностей не более 20 минут. Для прогрева и тестирования GPU при этом используются встроенные в чип специальные тесты. Технология закрытая, поддерживается пока только семейством GeForce RTX, и на Pascal она вряд ли заработает.

Эта возможность уже внедрена в такой известный инструмент как MSI AfterBurner. Пользователю этой утилиты доступно два основных режима: «Тест», в котором проверяется стабильность разгона GPU, и «Сканирование», когда алгоритмы Nvidia подбирают максимальные настройки разгона автоматически.

В режиме тестирования выдается результат стабильности работы в процентах (100% — полностью стабильно), а в режиме сканирования результат выводится в виде уровня разгона ядра в МГц, а также в виде измененной кривой частот/напряжения. Тестирование в MSI AfterBurner занимает около 5 минут, сканирование — 15-20 минут. В окне редактора кривой частот/напряжений можно увидеть текущие частоту и напряжение GPU, контролируя разгон. В режиме сканирования тестируется не вся кривая, а лишь несколько точек в выбранном диапазоне напряжений, в которых работает чип. Затем алгоритм находит максимально стабильный разгон для каждой из точек, повышая частоту при фиксированном напряжении. По завершении процесса OC Scanner пересылает в MSI Afterburner модифицированную кривую частот/напряжений.

Конечно, это далеко не панацея, и опытный любитель разгона выжмет из GPU еще больше. Да и автоматические средства разгона нельзя назвать абсолютно новыми, они существовали и раньше, хотя и показывали недостаточно стабильные и высокие результаты — разгон вручную практически всегда давал лучший результат. Однако, как отмечает Алексей Николайчук, автор MSI AfterBurner, технология Nvidia Scanner явно превосходит все предыдущие аналогичные средства. За время его испытаний этот инструмент ни разу не привел к краху ОС и всегда показывал стабильные (и достаточно высокие — порядка +10%-12%) частоты в результате. Да, GPU может зависать в процессе сканирования, но Nvidia Scanner всегда сам восстанавливает работоспособность и снижает частоты. Так что алгоритм реально неплохо работает и на практике.

Декодирование видеоданных и видеовыходы

Требования пользователей к поддержке устройств вывода постоянно растут — им хочется все бо́льших разрешений и максимального количества одновременно поддерживаемых мониторов. Самые продвинутые устройства имеют разрешение 8K (7680×4320 пикселей), требующее вчетверо большей пропускной способности по сравнению с 4K-разрешением (3820×2160), а энтузиасты компьютерных игр хотят максимально высокой частоты обновления информации на дисплеях — до 144 Гц и даже более.

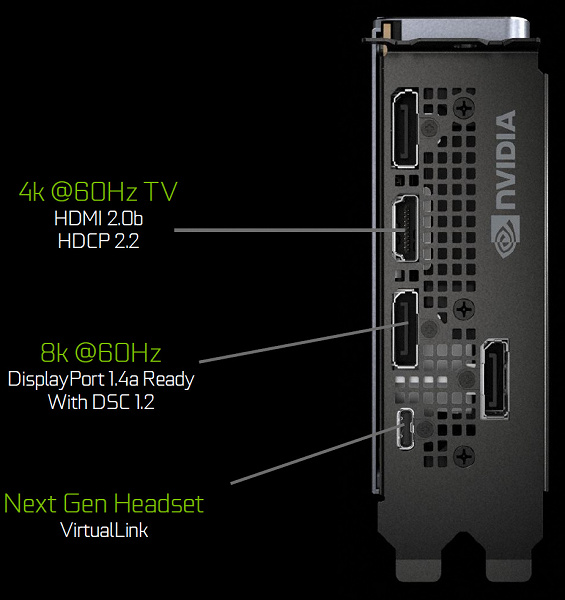

Графические процессоры семейства Turing содержат новый блок вывода информации, поддерживающий новые дисплеи с высоким разрешением, HDR и высокую частоту обновления. В частности, видеокарты линейки GeForce RTX имеют порты DisplayPort 1.4a, позволяющие вывести информацию на 8K-монитор с частотой обновления 60 Гц с поддержкой технологии VESA Display Stream Compression (DSC) 1.2, обеспечивающей высокую степень сжатия.

Платы Founders Edition содержат три выхода DisplayPort 1.4a, один разъем HDMI 2.0b (с поддержкой HDCP 2.2) и один VirtualLink (USB Type-C), предназначенный для будущих шлемов виртуальной реальности. Это новый стандарт подключения VR-шлемов, обеспечивающий передачу питания и высокую пропускную способность по USB-C. Такой подход значительно облегчает подключение шлемов. VirtualLink поддерживает четыре линии High BitRate 3 (HBR3) DisplayPort и линк SuperSpeed USB 3 для отслеживания движения шлема. Естественно, что использование разъема VirtualLink/USB Type-C требует дополнительного питания — до 35 Вт в плюс к объявленным 260 Вт типичного энергопотребления у GeForce RTX 2080 Ti.

Все решения семейства Turing поддерживают два 8K-дисплея при 60 Гц (требуется по одному кабелю на каждый), такое же разрешение также можно получить при подключении через установленный USB-C. Кроме этого, все Turing поддерживают полноценный HDR в конвейере вывода информации, включая tone mapping для различных мониторов — со стандартным динамическим диапазоном и широким.

Также новые GPU имеют улучшенный кодировщик видеоданных NVEnc, добавляющий поддержку компрессии данных в формате H.265 (HEVC) при разрешении 8K и 30 FPS. Новый блок NVEnc снижает требования к полосе пропускания до 25% при формате HEVC и до 15% при формате H.264. Также был обновлен и декодер видеоданных NVDec, получивший поддержку декодирования данных в формате HEVC YUV444 10-бит/12-бит HDR при 30 FPS, в формате H.264 при 8K-разрешении и в формате VP9 с 10-бит/12-бит данными.

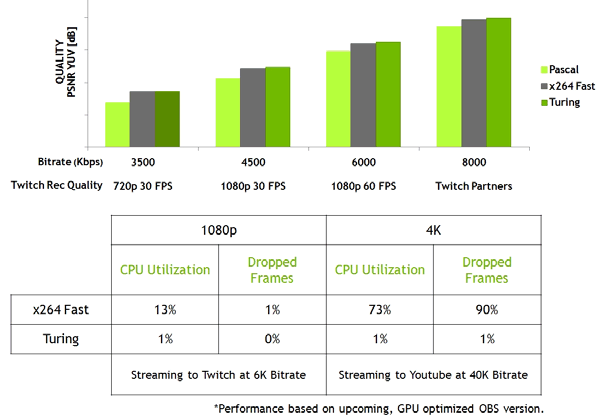

Семейство Turing еще и улучшает качество кодирования по сравнению с предыдущим поколением Pascal и даже по сравнению с программными кодировщиками. Кодировщик в новых GPU превосходит по качеству программный кодировщик x264, использующий быстрые (fast) настройки при значительно меньшем использовании ресурсов процессора. К примеру, стриминг видео в 4K-разрешении слишком тяжел для программных методов, а аппаратное кодирование видео на Turing способно исправить положение.

Графический ускоритель GeForce RTX 2080

Вместе с топовой видеокартой модели GeForce RTX 2080 Ti, компания Nvidia одновременно анонсировала и менее мощные варианты: RTX 2080 и RTX 2070, которые традиционно вызывают даже больший интерес публики, по сравнению с наиболее дорогой моделью, из-за лучшего соотношения цены и производительности. Рассмотрим средний вариант:

| Графический ускоритель GeForce RTX 2080 | |

|---|---|

| Кодовое имя чипа | TU104 |

| Технология производства | 12 нм FinFET |

| Количество транзисторов | 13,6 млрд. (у TU102 — 18,6 млрд.) |

| Площадь ядра | 545 мм² (у TU102 — 754 мм²) |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12_1 |

| Шина памяти | 256-битная: 8 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | 1515 (1710/1800) МГц |

| Вычислительные блоки | 46 (из 48 физически имеющихся в GPU) потоковых мультипроцессоров, включающих 2944 (из 3072) CUDA-ядра для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32 |

| Тензорные блоки | 368 (из 384) тензорных ядер для матричных вычислений INT4/INT8/FP16/FP32 |

| Блоки трассировки лучей | 46 (из 48) RT-ядер для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 184 (из 192) блока текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 8 широких блоков ROP (64 пикселя) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка подключения по интерфейсам HDMI 2.0b и DisplayPort 1.4a |

| Спецификации референсной видеокарты GeForce RTX 2080 | |

|---|---|

| Частота ядра | 1515 (1710/1800) МГц |

| Количество универсальных процессоров | 2944 |

| Количество текстурных блоков | 184 |

| Количество блоков блендинга | 64 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 256-бит |

| Объем памяти | 8 ГБ |

| Пропускная способность памяти | 448 ГБ/с |

| Вычислительная производительность (FP16/FP32) | до 21,2/10,6 терафлопс |

| Производительность трассировки лучей | 8 гигалучей/с |

| Теоретическая максимальная скорость закраски | 109-115 гигапикселей/с |

| Теоретическая скорость выборки текстур | 315-331 гигатекселей/с |

| Шина | PCI Express 3.0 |

| Разъемы | один HDMI и три DisplayPort |

| Энергопотребление | до 215/225 Вт |

| Дополнительное питание | один 8-контактный и один 6-контактный разъемы |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $699/$799 или 63990 руб. (Founders Edition) |

Как всегда, линейка GeForce RTX предлагает специальные продукты самой компании — так называемые Founders Edition. В этот раз при более высокой стоимости ($799 против $699 для рынка США — цены без учета налогов) они обладают и более привлекательными характеристиками. Приличный фабричный разгон у таких видеокарт есть изначально, а также видеокарты Founders Edition должны быть надежными и выглядят солидно благодаря отличному дизайну и грамотно подобранным материалам. А чтобы в надежности работы FE не было сомнений, каждая видеокарта тестируется на стабильность и обеспечивается трехлетней гарантией.

В видеокартах GeForce RTX Founders Edition применяется система охлаждения с испарительной камерой на всю длину печатной платы и с двумя вентиляторами для более эффективного охлаждения (по сравнению с одним вентилятором в предыдущих версиях FE). Длинная испарительная камера и большой двухслотовый алюминиевый радиатор обеспечивают довольно большую площадь рассеивания тепла, а тихие вентиляторы отводят горячий воздух в разные стороны, а не только наружу корпуса.

Система питания в GeForce RTX 2080 Founders Edition применяется весьма серьезная: 8-фазная схема iMon DrMOS (даже в GTX 1080 Ti Founders Edition была лишь 7-фазная dual-FET), поддерживающая новую динамическую систему управления питанием с более тонким контролем, улучшающая разгонные возможности видеокарты (о подробностях, связанных с разгоном, вы можете прочитать в обзоре RTX 2080 Ti). Для питания микросхем высокопроизводительной GDDR6-памяти установлена отдельная двухфазная схема.

Также FE-видеокарты Nvidia отличаются несколько большим уровнем энергопотребления, что обусловлено повышенными тактовыми частотами GPU. В этот раз партнерам компании было не так просто предложить еще более привлекательные варианты с фабричным разгоном, а пришлось делать экстремальные варианты с тремя разъемами дополнительного питания и усиленными системами охлаждения.

Архитектурные особенности

В модели видеокарты GeForce RTX 2080 применяется версия графического процессора TU104. Этот GPU имеет площадь 545 мм² (сравните с 754 мм² у TU102 и 610 мм² у топового чипа семейства Pascal — GP100) и содержит 13,6 млрд. транзисторов, по сравнению с 18,6 млрд. транзисторов у TU102 и 15,3 млрд. транзисторов у GP100. Так как новые GPU усложнились из-за появления аппаратных блоков, которых не было в Pascal, а техпроцессы применяются схожие, то по площади все новые чипы увеличились, если сравнивать схожие по наименованию модели.

Полный чип TU104 содержит шесть кластеров Graphics Processing Cluster (GPC), каждый из которых содержит четыре кластера Texture Processing Cluster (TPC), состоящих из одного движка PolyMorph Engine и пары мультипроцессоров SM. Соответственно, каждый SM состоит из: 64 CUDA-ядер, 256 КБ регистровой памяти и 96 КБ конфигурируемых L1-кэша и общей памяти, а также четырех блоков текстурирования TMU. Для нужд аппаратной трассировки лучей каждый мультипроцессор SM имеет также и по одному RT-ядру. Всего в полном чипе получается 48 мультипроцессоров SM, столько же RT-ядер, 3072 CUDA-ядер и 384 тензорных ядра.

Но это характеристики именно полного чипа TU104, различные модификации которого используются в моделях: GeForce RTX 2080, Tesla T4 и Quadro RTX 5000. В частности, рассматриваемая сегодня модель GeForce RTX 2080 основана на урезанной версии чипа с двумя аппаратно отключенными блоками SM. Соответственно, активными в ней остались: 2944 CUDA-ядра, 46 RT-ядра, 368 тензорных ядер и 184 блока текстурирования TMU.

А вот подсистема памяти в GeForce RTX 2080 полноценная, она содержит восемь 32-битных контроллеров памяти (256-бит в целом), при помощи которых GPU имеет доступ к 8 ГБ GDDR6-памяти, работающей на эффективной частоте в 14 ГГц, что дает пропускную способность в очень приличные 448 ГБ/с в итоге. К каждому контроллеру памяти привязаны по восемь блоков ROP и по 512 КБ кэш-памяти второго уровня. То есть, всего в чипе 64 блока ROP и 4 МБ L2-кэша.

Что касается тактовых частот нового графического процессора, то турбо-частота GPU у референсной карты равна 1710 МГц. Как и старшая модель GeForce RTX 2080 Ti, предлагаемая компанией со своего сайта видеокарта RTX 2080 Founders Edition имеет фабричный разгон до 1800 МГц — на 90 МГц больше, чем у референсных вариантов (хотя что такое референсные карты теперь — вопрос интересный).

По строению мультипроцессоров SM все чипы новой архитектуры Turing схожи друг с другом, в них появились новые типы вычислительных блоков: тензорные ядра и ядра ускорения трассировки лучей, а также были усложнены сами CUDA-ядра, в которых появилась возможность одновременного исполнения целочисленных вычислений и операций с плавающей запятой. Обо всех архитектурных изменениях мы очень подробно сообщали в обзоре GeForce RTX 2080 Ti, и очень советуем с ним ознакомиться.

Архитектурные изменения в вычислительных блоках привели к 50%-ному улучшению производительности шейдерных процессоров при равной тактовой частоте в играх в среднем. Также были улучшены технологии сжатия информации без потерь, архитектура Turing поддерживает новые техники компрессии, до 50% более эффективные по сравнению с алгоритмами в семействе чипов Pascal. Вместе с применением нового типа памяти GDDR6 это дает приличный прирост эффективной ПСП.

Это еще далеко не весь список нововведений и улучшений в Turing. Многие изменения в новой архитектуре нацелены на будущее, вроде mesh shading — новых шейдеров, ответственных за всю работу над геометрией, вершинами, тесселяцией и т. д., позволяющих значительно снизить зависимость от мощности CPU и во много раз увеличить количество объектов в сцене. Или взять Variable Rate Shading (VRS) — шейдинг с переменным количеством сэмплов, позволяющий оптимизировать рендеринг при помощи переменного количества сэмплов закраски, упрощая шейдинг лишь там, где это оправдано.

Отметим внедрение высокопроизводительного интерфейса NVLink второй версии, который используется для объединения GPU в том числе и для работы над изображением в режиме SLI. Топовый чип TU102 имеет два порта NVLink второго поколения, а в TU104 есть лишь один такой порт, но его пропускной способности в 50 ГБ/с хватит для передачи кадрового буфера с разрешением 8К в режиме многочипового рендеринга AFR от одного GPU к другому. Такая скорость позволяет использовать локальную видеопамять соседнего GPU как свою собственную полностью автоматически, без сложного программирования.

Графические процессоры семейства Turing также содержат новый блок вывода информации, поддерживающий дисплеи с высоким разрешением, с HDR и высокой частотой обновления. В частности, GeForce RTX имеют порты DisplayPort 1.4a, позволяющие вывести информацию на 8K-монитор с частотой обновления 60 Гц с поддержкой технологии VESA Display Stream Compression (DSC) 1.2, обеспечивающей высокую степень сжатия.

Платы Founders Edition содержат три таких выхода DisplayPort 1.4a, один разъем HDMI 2.0b (с поддержкой HDCP 2.2) и один VirtualLink (USB Type-C), предназначенный для будущих шлемов виртуальной реальности. Это новый стандарт подключения VR-шлемов, обеспечивающий передачу питания и высокую пропускную способность по разъему USB-C.

Все решения семейства Turing поддерживают два 8K-дисплея при 60 Гц (требуется по одному кабелю на каждый), такое же разрешение также можно получить при подключении через установленный USB-C. Кроме этого, все Turing поддерживают полноценный HDR в конвейере вывода информации, включая tone mapping для различных мониторов — со стандартным динамическим диапазоном и расширенным.

Новые GPU содержат улучшенный кодировщик видеоданных NVEnc, добавляющий поддержку сжатия данных в формате H.265 (HEVC) при разрешении 8K и 30 FPS. Такой блок NVEnc снижает требования к полосе пропускания до 25% при формате HEVC и до 15% при формате H.264. Также был обновлен и декодер видеоданных NVDec, получивший поддержку декодирования данных в формате HEVC YUV444 10-бит/12-бит HDR при 30 FPS, в формате H.264 при 8K-разрешении и в формате VP9 с 10-бит/12-бит данными.

Графический ускоритель GeForce RTX 2070

Вместе с топовой и средней моделей видеокарт, компания Nvidia анонсировала и самую доступную модель — GeForce RTX 2070, на которую рассчитывают многие любители игр из-за сравнительно низкой цены и хорошего соотношения цены и производительности. Достаточно ли мощности для современных игр с применением трассировки лучей у младшей модели?

| Графический ускоритель GeForce RTX 2070 | |

|---|---|

| Кодовое имя чипа | TU106 |

| Технология производства | 12 нм FinFET |

| Количество транзисторов | 10,8 млрд (у TU104 — 13,6 млрд) |

| Площадь ядра | 445 мм² (у TU104 — 545 мм²) |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12_1 |

| Шина памяти | 256-битная: 8 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | 1410 (1620/1710) МГц |

| Вычислительные блоки | 36 потоковых мультипроцессоров, включающих 2304 CUDA-ядра для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32 |

| Тензорные блоки | 288 тензорных ядер для матричных вычислений INT4/INT8/FP16/FP32 |

| Блоки трассировки лучей | 36 RT-ядер для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 144 блока текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 8 широких блоков ROP (64 пикселя) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка подключения по интерфейсам HDMI 2.0b и DisplayPort 1.4a |

| Спецификации референсной видеокарты GeForce RTX 2070 | |

|---|---|

| Частота ядра | 1410 (1620/1710) МГц |

| Количество универсальных процессоров | 2304 |

| Количество текстурных блоков | 144 |

| Количество блоков блендинга | 64 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 256-бит |

| Объем памяти | 8 ГБ |

| Пропускная способность памяти | 448 ГБ/с |

| Вычислительная производительность (FP16/FP32) | до 15,8/7,9 терафлопс |

| Производительность трассировки лучей | 6 гигалучей/с |

| Теоретическая максимальная скорость закраски | 104—109 гигапикселей/с |

| Теоретическая скорость выборки текстур | 233—246 гигатекселей/с |

| Шина | PCI Express 3.0 |

| Разъемы | один HDMI и три DisplayPort |

| Энергопотребление | до 175/185 Вт |

| Дополнительное питание | один 8-контактный и один 6-контактный разъемы |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $499/$599 или 42/49 тысяч рублей |

Founders Edition в этот раз при несколько более высокой стоимости ($599 против $499 для рынка США — цены без учета налогов) они обладают и более привлекательными характеристиками. У таких видеокарт есть изначально весьма приличный фабричный разгон, а также видеокарты Founders Edition должны быть надежными и они выглядят очень солидно из-за строгого дизайна и специально подобранных материалов.

Чтобы в надежности работы таких FE-видеокарт не оставалось сомнений, каждая плата тестируется на стабильность и обеспечивается трехлетней гарантией. Что оказалось весьма полезным делом, так как в некоторых из видеокарт первых партий топового решения допустили брак — но все вышедшие из строя такие карты без проблем заменяются по гарантии.

В видеокартах GeForce RTX Founders Edition применяется оригинальная система охлаждения с испарительной камерой на всю длину печатной платы и с двумя вентиляторами — для более эффективного охлаждения (по сравнению с одним вентилятором в предыдущих версиях FE). Длинная испарительная камера и большой двухслотовый алюминиевый радиатор обеспечивают довольно большую площадь рассеивания тепла, а тихие вентиляторы отводят горячий воздух в разные стороны, а не только наружу корпуса. В последнем есть и плюс и минус. К примеру, при очень плотном размещении видеокарт (не через слот, а в каждом) они могут перегреваться, ведь это — не самые обычные условия работы для GeForce.

Кроме описанных отличий, FE-видеокарты отличаются и несколько большим уровнем энергопотребления, что обусловлено повышенными тактовыми частотами GPU для таких вариантов. В этот раз партнерам компании приходится предлагать варианты с еще большим фабричным разгоном — экстремальные варианты с лучшими характеристиками по дополнительному питанию, а также усиленными системами охлаждения.

Архитектурные особенности

Младшая модель видеокарты GeForce RTX 2070 основана на графическом процессоре TU106. Этот GPU используется только для этой платы и имеет площадь 445 мм² (сравните с 545 мм² у TU104, на котором сделан RTX 2080, и с 471 мм² у лучшего игрового чипа семейства Pascal — GP102, основе GeForce GTX 1080 Ti), содержит 10,8 млрд транзисторов, по сравнению с 13,6 млрд транзисторов у среднего TU104 и с 12 млрд транзисторов у GP102 — основе GTX 1080 Ti.

Полная версия чипа TU106 содержит три кластера Graphics Processing Cluster (GPC), каждый из которых содержит по шесть кластеров Texture Processing Cluster (TPC), состоящих из одного движка PolyMorph Engine и пары мультипроцессоров SM. Соответственно, каждый SM состоит из: 64 CUDA-ядер, 256 КБ регистровой памяти и 96 КБ конфигурируемых L1-кэша и общей памяти, а также четырех блоков текстурирования TMU. Для нужд аппаратной трассировки лучей каждый мультипроцессор SM имеет также и по одному RT-ядру. Всего чип включает 36 мультипроцессоров SM, столько же RT-ядер, 2304 CUDA-ядер и 288 тензорных ядер.

Рассматриваемая нами модель GeForce RTX 2070 основана на полной версии этого чипа, поэтому все указанные характеристики соответствуют также и ей. Подсистема памяти аналогична той, что мы видели в TU104 и GeForce RTX 2080, она содержит восемь 32-битных контроллеров памяти (256-бит в целом), при помощи которых GPU имеет доступ к 8 ГБ GDDR6-памяти, работающей на эффективной частоте в 14 ГГц, что дает пропускную способность в очень приличные 448 ГБ/с в итоге. К каждому контроллеру памяти привязаны по восемь блоков ROP и по 512 КБ кэш-памяти второго уровня. То есть, всего в чипе 64 блока ROP и 4 МБ L2-кэша.

Что касается тактовых частот нового графического процессора в составе младшей модели линейки GeForce RTX, то турбо-частота GPU у референсного варианта (не путать с FE!) карты составляет 1620 МГц. Как и две другие модели линейки, предлагаемая компанией со своего сайта видеокарта RTX 2070 Founders Edition имеет фабричный разгон до 1710 МГц — на 90 МГц больше, чем у стандартных вариантов от производителей видеокарт.

По строению мультипроцессоров SM все чипы новой архитектуры Turing схожи друг с другом, в них появились новые типы вычислительных блоков: тензорные ядра и ядра ускорения трассировки лучей, а также были усложнены сами CUDA-ядра, в которых появилась возможность одновременного исполнения целочисленных вычислений и операций с плавающей запятой. Обо всех важных изменениях мы очень подробно сообщали в обзоре GeForce RTX 2080 Ti, и очень советуем ознакомиться с этим большим и важным материалом.

Архитектурные изменения в вычислительных блоках привели к 50%-ному улучшению производительности шейдерных процессоров при равной тактовой частоте в среднем. Также были улучшены технологии сжатия информации без потерь, архитектура Turing поддерживает новые техники компрессии, также до 50% более эффективные, по сравнению с алгоритмами в семействе чипов Pascal. Вместе с применением нового типа памяти GDDR6 это дает приличный прирост эффективной ПСП. Хотя конкретно у RTX 2070 пропускной способности памяти и так довольно много — не меньше, чем у RTX 2080.

Многие изменения в новой архитектуре Turing нацелены на будущее, вроде mesh shading — новых типов шейдеров, ответственных за всю работу над геометрией, вершинами, тесселяцией и т. д. Если вкратце, то они позволяют значительно снизить зависимость от мощности CPU и во много раз увеличить количество объектов в сцене.

Очень важно отметить, что поддержки высокопроизводительного интерфейса NVLink второй версии, который используется для объединения GPU в том числе и для работы над изображением в режиме SLI, конкретно в младшем чипе линейки TU106 нет, хотя в TU102 в наличии два порта NVLink, а в TU104 — один. Похоже, в компании Nvidia таким образом разделяют рынки, предлагая заинтересованным в SLI-системах приобретать более дорогие варианты графических карт.

А вот новый блок вывода информации, поддерживающий дисплеи с высоким разрешением, с HDR и высокой частотой обновления, есть во всех графических процессорах семейства Turing, в том числе и в TU106. Все GeForce RTX имеют порты DisplayPort 1.4a, позволяющие вывести информацию на 8K-монитор с частотой обновления 60 Гц с поддержкой технологии VESA Display Stream Compression (DSC) 1.2, обеспечивающей высокую степень сжатия.

Платы Founders Edition содержат три таких выхода DisplayPort 1.4a, один разъем HDMI 2.0b (с поддержкой HDCP 2.2) и один VirtualLink (USB Type-C), предназначенный для будущих шлемов виртуальной реальности. Это новый стандарт подключения VR-шлемов, обеспечивающий передачу питания и высокую пропускную способность по разъему USB-C.

Все решения семейства Turing поддерживают два 8K-дисплея при 60 Гц (требуется по одному кабелю на каждый), такое же разрешение также можно получить при подключении через установленный USB-C. Кроме этого, все Turing поддерживают полноценный HDR в конвейере вывода информации, включая tone mapping для различных мониторов — со стандартным динамическим диапазоном и расширенным.

Все новые GPU также содержат улучшенный кодировщик видеоданных NVEnc, добавляющий поддержку сжатия данных в формате H.265 (HEVC) при разрешении 8K и 30 FPS. Такой блок NVEnc снижает требования к полосе пропускания до 25% при формате HEVC и до 15% при формате H.264. Также был обновлен и декодер видеоданных NVDec, получивший поддержку декодирования данных в формате HEVC YUV444 10-бит/12-бит HDR при 30 FPS, в формате H.264 при 8K-разрешении и в формате VP9 с 10-бит/12-бит данными.

Графический ускоритель GeForce RTX 2060

Ещё чуть позже настало время самой младшей модели в новом семействе – GeForce RTX 2060. С момента анонса старших видеокарт на Gamescom прошло почти полгода, Nvidia первым снимала сливки с дорогих продуктов, когда одна за одной были выпущены модели GeForce RTX 2080 Ti, GeForce RTX 2080 и GeForce RTX 2070, а бюджетную (относительно) видеокарту придержала.

Неудивительно, что появился и некоторый негатив, связанный с выходом дорогих решений линейки GeForce RTX. И речь не только о топовой GeForce RTX 2080 Ti, которая хоть и имеет потрясающую производительность и новую функциональность, но выделяется очень высокой ценой, которая отпугнула многих пользователей. Остальные решения семейства Turing из первой тройки не блистали доступностью розничных цен. Конечно, повышенным ценам есть вполне логичные объяснения, но. мотивацию для покупки они добавляют не всегда. Многие потенциальные покупатели ждали более доступной видеокарты.

И вот она появилась — в начале января 2019 года глава компании Nvidia анонсировал GeForce RTX 2060 на отраслевой конференции CES. К слову, даже сам Дженсен Хуанг признал, что стоимость первых трех выпущенных GeForce RTX слишком высока для массового распространения новых Turing с революционными функциями аппаратной трассировки лучей и ускорения тензорных вычислений. А ведь Nvidia сама кровно заинтересована в том, чтобы GPU с новыми функциями завоевывали рынок. Но так как это вряд ли возможно с ценами на видеокарты от $500 и выше, то на рынок вышла и GeForce RTX 2060 за $349.

Эта цена также превышает то значение, к которому мы привыкли для GPU этого уровня, ведь на момент своего анонса та же GeForce GTX 1060 стоила на сотню дешевле. Но в любом случае, GeForce RTX 2060 стала самой доступной моделью с аппаратным ускорением трассировки лучей и глубокого обучения. Она интересна еще и потому, что должна дать более ощутимый прирост производительности при смене поколения GPU. Эта модель стала не просто наиболее доступным, но и самым выгодным решением из всего нового семейства.

| Графический ускоритель GeForce RTX 2060 | |

|---|---|

| Кодовое имя чипа | TU106 |

| Технология производства | 12 нм FinFET |

| Количество транзисторов | 10,8 млрд |

| Площадь ядра | 445 мм² |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12_1 |

| Шина памяти | 192-битная: 6 (из 8 имеющихся) независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | 1365 (1680) МГц |

| Вычислительные блоки | 30 (из 36 имеющихся) потоковых мультипроцессоров, включающих 1920 (из 2304) CUDA-ядер для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32 |

| Тензорные блоки | 240 (из 288) тензорных ядер для матричных вычислений INT4/INT8/FP16/FP32 |

| Блоки трассировки лучей | 30 (из 36) RT-ядер для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 120 (из 144) блоков текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 6 (из  широких блоков ROP (48 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра широких блоков ROP (48 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка подключения по интерфейсам HDMI 2.0b и DisplayPort 1.4a |

| Спецификации референсной видеокарты GeForce RTX 2060 | |

|---|---|

| Частота ядра | 1365 (1680) МГц |

| Количество универсальных процессоров | 1920 |

| Количество текстурных блоков | 120 |

| Количество блоков блендинга | 48 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 192-бит |

| Объем памяти | 6 ГБ |

| Пропускная способность памяти | 336 ГБ/с |

| Вычислительная производительность (FP16/FP32) | до 12,9/6,5 терафлопс |

| Производительность трассировки лучей | 5 гигалучей/с |

| Теоретическая максимальная скорость закраски | 81 гигапиксель/с |

| Теоретическая скорость выборки текстур | 202 гигатекселя/с |

| Шина | PCI Express 3.0 |

| Разъемы | один HDMI, один DVI и два DisplayPort |

| Энергопотребление | до 160 Вт |

| Дополнительное питание | один 8-контактный разъем |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $349 (31 990 рублей) |

Как и в случае старших моделей, для RTX 2060 предлагается и специальный продукт от самой компании — так называемый Founders Edition. В этот раз FE-издание не отличается ни иной стоимостью, ни более привлекательными частотными характеристиками. Nvidia убрала фабричный разгон для FE-варианта GeForce RTX 2060, и все недорогие карты должны иметь схожие характеристики по частоте — GPU работает на турбо-частоте в 1680 МГц, а GDDR6-память имеет частоту в 14 ГГц.

Видеокарты Founders Edition должны быть довольно надежными, да и выглядят они солидно из-за строгого дизайна и грамотно подобранных материалов. В RTX 2060 применяется та же система охлаждения с испарительной камерой на всю длину печатной платы и двумя вентиляторами — для более эффективного охлаждения (по сравнению с одним вентилятором в предыдущих версиях). Длинная испарительная камера и большой двухслотовый алюминиевый радиатор обеспечивают большую площадь рассеивания тепла, а тихие вентиляторы отводят горячий воздух в разные стороны, а не только наружу корпуса.

Видеокарты модели GeForce RTX 2060 поступили в продажу с 15 января в виде Nvidia Founders Edition и решениях партнеров, включая компании Asus, Colorful, EVGA, Gainward, Galaxy, Gigabyte, Innovision 3D, MSI, Palit, PNY и Zotac — с собственным дизайном и характеристиками. А чтобы еще больше улучшить привлекательность новинки, Nvidia объявила о комплектации видеокарты игрой Anthem или Battlefield V — на выбор пользователя, купившего GeForce RTX 2060 или готовую систему на его основе.

Архитектурные особенности

В случае модели GeForce RTX 2060, многое пришлось делать совсем не так, как в предыдущих поколениях. Это связано как с добавлением специализированных блоков, серьезно усложнивших GPU, так и с отсутствием серьезной смены техпроцесса. Вот если бы графические процессоры Turing вышли сразу на техпроцессе 7 нм (правда, позже на год), то вполне возможно, что Nvidia бы даже удержала цены в привычных диапазонах для всех решений линейки. Но не в этот раз.

Видеокарты уровня x60 (260, 460, 660, 760, 1060 и другие) всегда были основаны на отдельной модели GPU средней сложности, оптимизированного для этой самой золотой середины. А в нынешнем поколении это тот же чип, что и для RTX 2070, но урезанный по количеству исполнительных блоков. Давайте сравним характеристики нескольких моделей видеокарт Nvidia двух последних поколений:

| RTX 2070 | GTX 1070 Ti | GTX 1070 | RTX 2060 | GTX 1060 | |

|---|---|---|---|---|---|

| Кодовое имя GPU | TU106 | GP104 | GP104 | TU106 | GP106 |

| Кол-во транзисторов, млрд | 10,8 | 7,2 | 7,2 | 10,8 | 4,4 |

| Площадь кристалла, мм² | 445 | 314 | 314 | 445 | 200 |

| Базовая частота, МГц | 1410 | 1607 | 1506 | 1365 | 1506 |

| Турбо-частота, МГц | 1620 (1710) | 1683 | 1683 | 1680 | 1708 |

| CUDA-ядра, шт | 2304 | 2432 | 1920 | 1920 | 1280 |

| Производительность FP32, GFLOPS | 7465 (7880) | 8186 | 6463 | 6221 | 3855 |

| Тензорные ядра, шт | 288 | 0 | 0 | 240 | 0 |

| RT-ядра, шт | 36 | 0 | 0 | 30 | 0 |

| Блоки ROP, шт | 64 | 64 | 64 | 48 | 48 |

| Блоки TMU, шт | 144 | 152 | 120 | 120 | 80 |

| Объем видеопамяти, ГБ | 8 | 8 | 8 | 6 | 6 |

| Шина памяти, бит | 256 | 256 | 256 | 192 | 192 |

| Тип памяти | GDDR6 | GDDR5 | GDDR5 | GDDR6 | GDDR5 |

| Частота памяти, ГГц | 14 | 8 | 8 | 14 | 8 |

| ПСП памяти, ГБ/с | 448 | 256 | 256 | 336 | 192 |

| Энергопотребление TDP, Вт | 175 (185) | 180 | 150 | 160 | 120 |

| Рекомендованная цена, $ | 499 (599) | 449 | 379 | 349 | 249(299) |